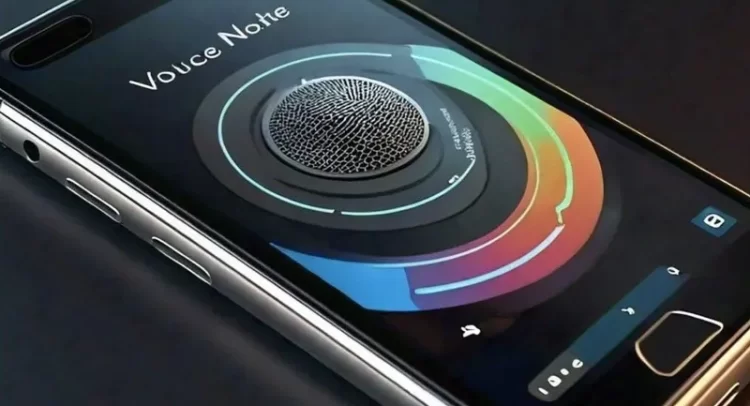

El Instituto Nacional de Ciberseguridad (Incibe) ha alertado sobre un novedoso método de estafa que utiliza la Inteligencia Artificial (IA) para replicar la voz de familiares y solicitar ayuda. Esta técnica se ha manifestado tanto en llamadas telefónicas como en mensajes de voz a través de WhatsApp.

Recientemente, un individuo reportó a la Línea de Ayuda en Ciberseguridad del Incibe (017) un intento de fraude en el que se escuchaba la voz de su marido. Según el instituto, los estafadores pueden generar audios que imitan el tono de una persona con solo unos segundos de grabación.

Los cibercriminales suelen realizar múltiples llamadas en las que la víctima responde sin obtener respuesta, y a menudo utilizan videos de las víctimas en redes sociales para mejorar la calidad de la suplantación. Este modus operandi consiste en pedir que se envíe un mensaje a un número específico, lo que puede llevar a la víctima a compartir datos personales o realizar transferencias de dinero.

Para protegerse, el Incibe recomienda verificar la identidad de los contactos antes de actuar. En caso de recibir una llamada sospechosa, se sugiere utilizar medios alternativos para comunicarse y no proporcionar información personal. Además, se puede reportar cualquier intento de estafa al número 088 o a través de las redes sociales de las autoridades.

Fuente: Cortesía